Heutzutage überrascht es niemanden mehr, dass jedes Gerät das Etikett „smart“ erhält. Telefone, Fernseher, Kühlschränke, Thermostate, Kopfhörer… und jetzt wieder Brillen. Die Idee ist einfach: einen Computer, ein Display, eine Kamera und Mikrofone in einem Alltagsgegenstand unterzubringen und vorzugeben, dass er plötzlich „nützlicher“ wird. Das Problem ist, dass dies nicht immer auf natürliche Weise gelingt.

Smartphones und Smart-TVs haben sich blitzschnell durchgesetzt. Aber „Smartgläser“? Das ist seit Jahren ein harter Brocken. Die meisten Menschen tragen einfach keine Brillen – einige haben gutes Sehvermögen, und der Rest wählt Kontaktlinsen. Wer ist also die Zielgruppe? Brillenträger? Fans teurer Ray-Bans? Oder geht es darum, die Funktionen eines Telefons direkt ins Gesicht zu übertragen?

Hinzu kommt die Frage der Privatsphäre. Kameras und Mikrofone, die immer eingeschaltet sind – das klingt für viele wie ein Albtraum. Google Glass erhielt 2013 sogar den Spitznamen „glassholes“ für Benutzer, die die Konventionen und das Empfinden der Privatsphäre anderer Menschen komplett ignorierten.

Was können Ray-Ban Display-Brillen?

Die neuen Meta- und Ray-Ban-Brillen sind eine ziemlich spezifische Mischung. Im rechten Glas haben wir ein farbiges Display mit 600 × 600 px, einen Sichtwinkel von 20°, und dazu eine 12 MP Kamera, sechs Mikrofone und Stereo-Lautsprecher. Es handelt sich nicht um vollwertige AR, sondern eher um einen kleinen Bildschirm, der erscheint, wenn du leicht nach rechts schaust.

Das interessanteste Zubehör ist jedoch das EMG-Band – das sogenannte Neural Band. Es liest elektrische Signale aus den Handgelenksmuskeln, um Handgesten zu erkennen. Theoretisch wird es sogar ermöglichen, in die Luft zu schreiben – obwohl die Funktion momentan in der „Beta“-Version ist.

Im Vergleich zu Google Glass: ein stärkerer Prozessor, mehr Flash-Speicher, schnellerer RAM – aber immer noch nur 2 GB. Die Gestensteuerung an der Seite des Rahmens ist praktisch die gleiche, und der größte Unterschied ist das Band am Arm. Der Haken? Ein weiteres Gadget, das man aufladen muss. Und wenn du schon eine Smartwatch trägst, bleibt wahrscheinlich nur noch die zweite Hand.

Das ewige Problem – wozu braucht man das?

Google Glass, Apple Vision Pro und der ganze Rest hatten ein gemeinsames Problem: Niemand wusste, wozu sie wirklich dienen sollten. Mails oder Katzenfotos auf einem kleinen Bildschirm durchsehen? Navigation im Stil von „Karte im Augenwinkel“? Alles schön und gut, bis man das Telefon zur Hand nehmen muss, um sich zu vergewissern, dass man tatsächlich in die richtige Richtung geht.

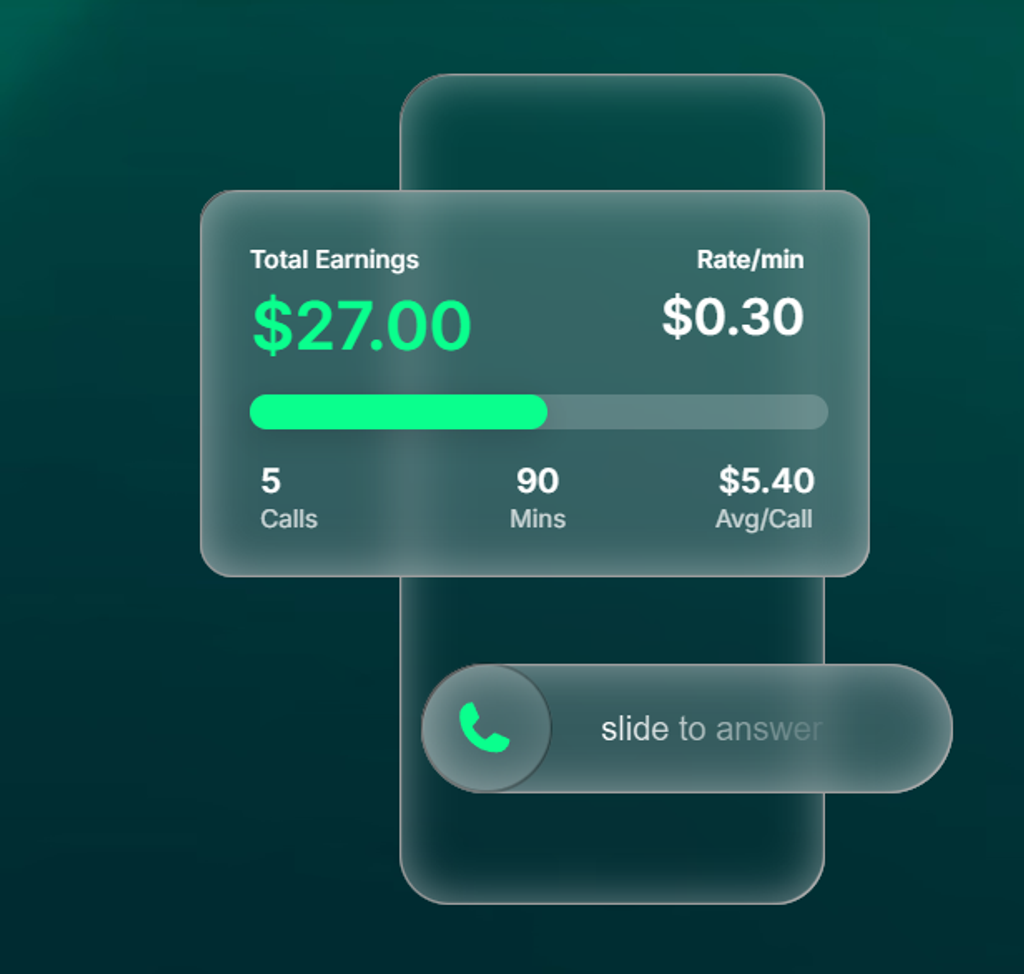

Meta setzt auf Integration mit Meta AI – Echtzeit-Spracherkennung, Untertitelübersetzungen, schnelle Antworten. Klingt nicht schlecht, aber das kann ein gewöhnliches Smartphone ebenso gut, mit einem viel größeren Bildschirm und einer besseren Benutzeroberfläche.

Alte Ängste, neue Brillen

Im Hintergrund bleibt die Frage des „Panoptikums“ – also das Gefühl, dass man immer und überall beobachtet werden könnte. Smartphones zeigen wenigstens klar, wann jemand aufnimmt. Smart Glasses? Nicht immer. Ein winziger LED-Indikator? Leicht zu übersehen.

Es ist kein Wunder, dass die Menschen nervös reagieren. Auf TikTok erschien ein Video einer Frau, die entdeckte, dass die Person, die sie im Salon enthaarte, solche Brillen trug. Sieht lustig aus, aber es ist nicht schwer zu verstehen, warum sie sich unwohl fühlte.

Das Problem ist also dasselbe wie bei Google Glass: Wie kann man „Innovation“ mit der Tatsache in Einklang bringen, dass sich andere ohne Zustimmung gefilmt fühlen? Und was ist, wenn das deine einzigen korrigierenden Brillen sind – musst du sie jedes Mal abnehmen, wenn du ins Kino oder ins Museum gehst?

Dummere „smart” Versionen

Nicht alle Smart-Brillen müssen eine Kamera haben. Es gibt zum Beispiel automatisch verdunkelte Sonnenbrillen oder Modelle, die als zusätzlicher Bildschirm für Laptops fungieren. Es gibt auch typischen AR-Konstruktionen, die nicht so viel Kontroversen auslösen. Aber sie ziehen nicht die Aufmerksamkeit der Medien auf sich – und sie tragen nicht das Etikett „glassholes”.

Dummere „Smart”-Versionen

Nicht alle Smart-Brillen müssen eine Kamera haben. Es gibt zum Beispiel automatisch abgedunkelte Sonnenbrillen oder Modelle, die als zusätzlicher Bildschirm für Laptops fungieren. Es gibt auch typischen AR-Konstruktionen, die nicht so viel Kontroversen auslösen. Aber nicht sie ziehen die Aufmerksamkeit der Medien auf sich – und nicht sie tragen das Stigma der „Glassholes”.

Katarzyna Petru

Katarzyna Petru